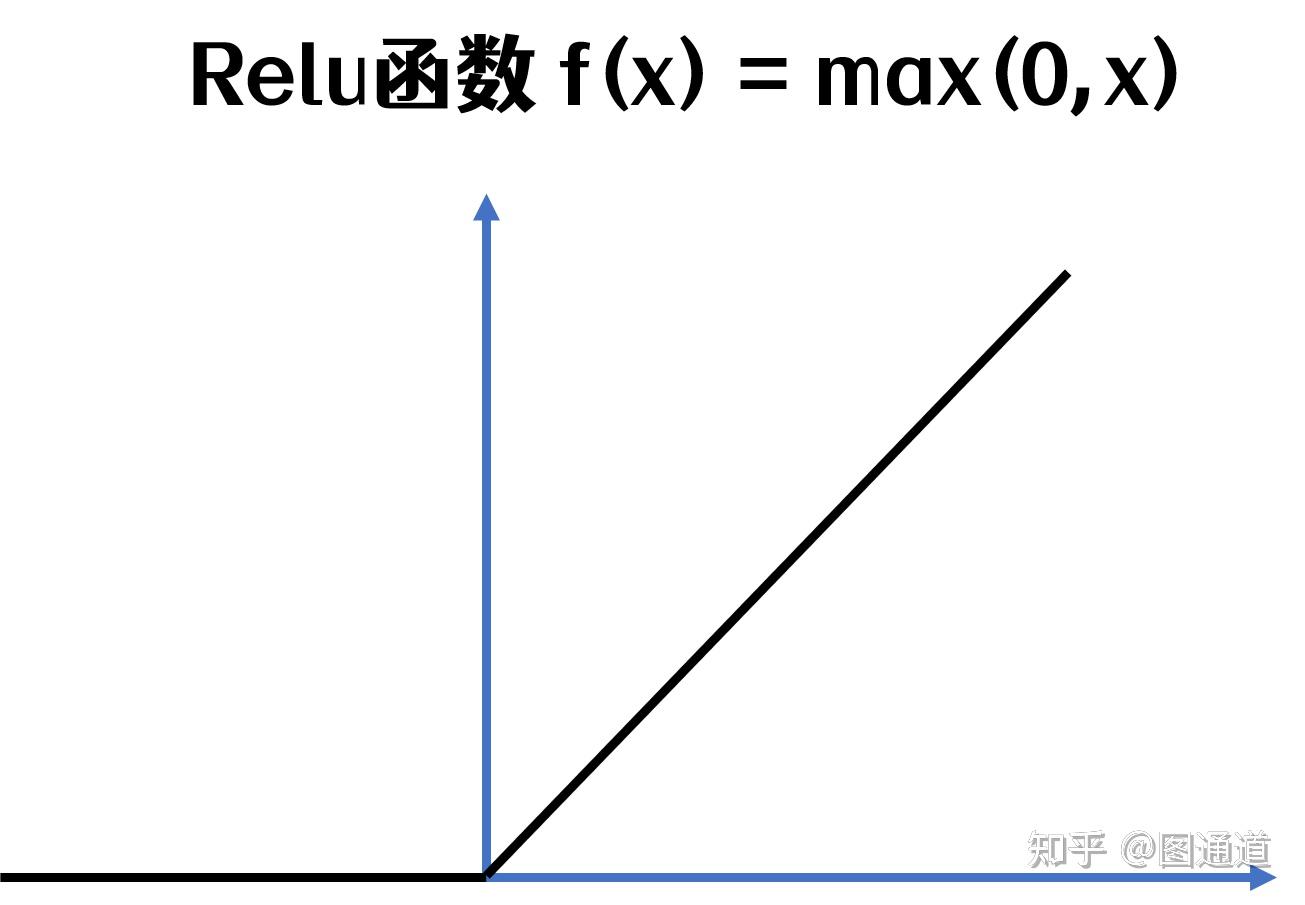

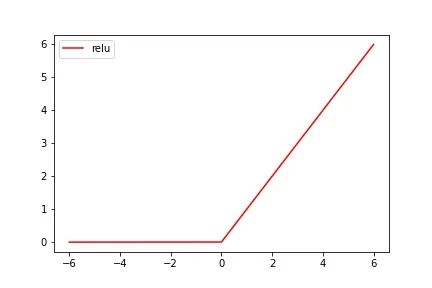

relu

3 激活层(relu)

图片尺寸1305x905

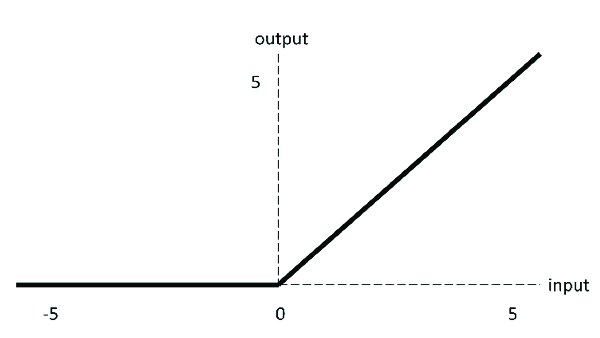

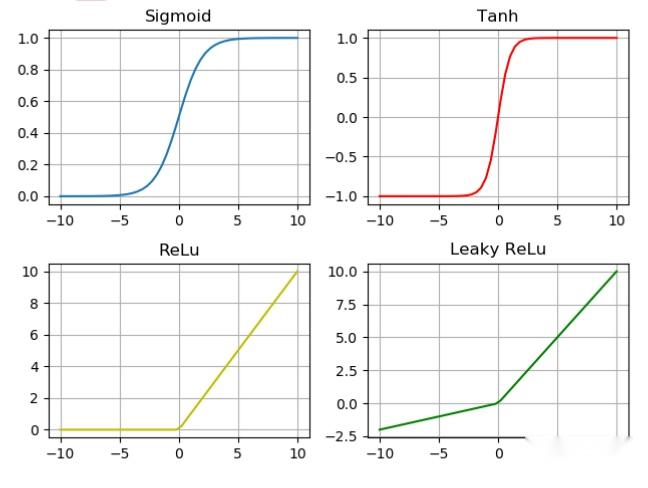

激活函数总结1relu及其变体

图片尺寸864x764

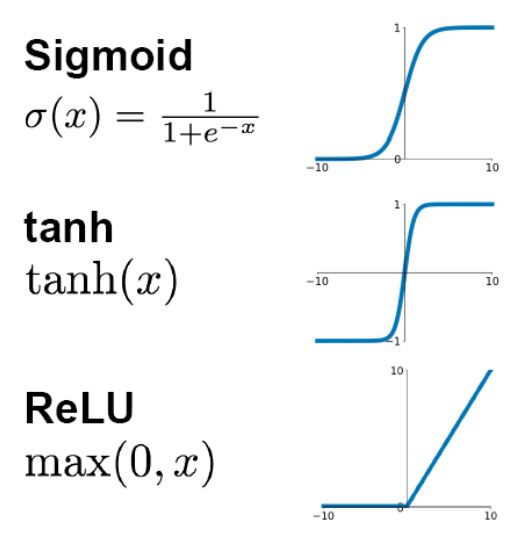

relu

图片尺寸600x338

面试题人工神经网络中为什么relu要好过于tanh和sigmoid

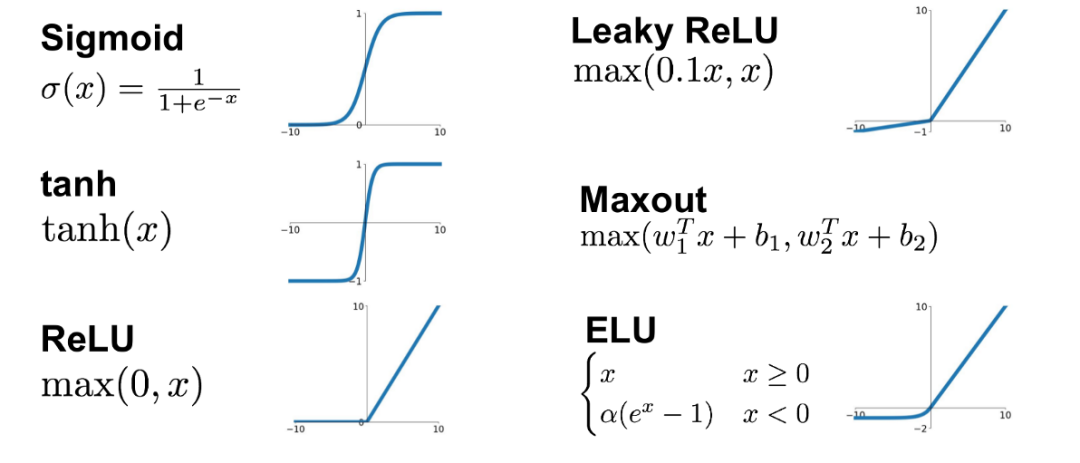

图片尺寸526x541

流号/餐漫集结社 @reluvv6213 @acg动漫君 天 - 抖音

图片尺寸690x985

1. relu作为激活函数

图片尺寸584x225

relu激活函数out了正弦周期激活函数在隐式神经表示中大显神威

图片尺寸1080x463

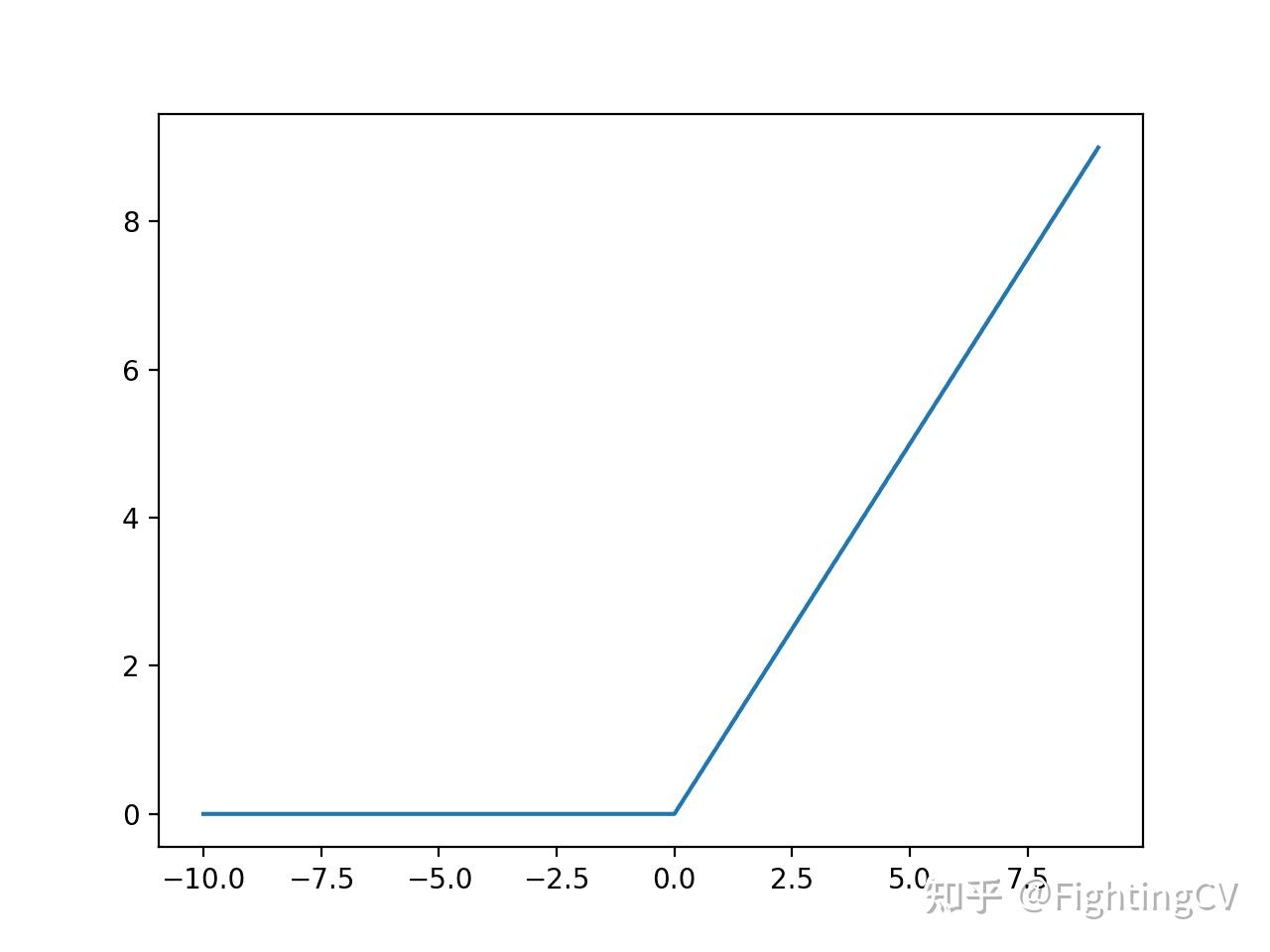

修正线性单元(relu)

图片尺寸396x252

relu函数

图片尺寸432x288

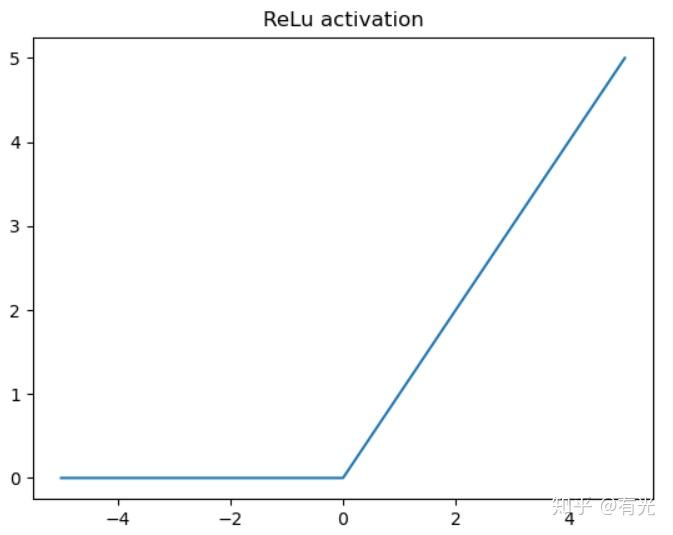

relu激活函数

图片尺寸648x488

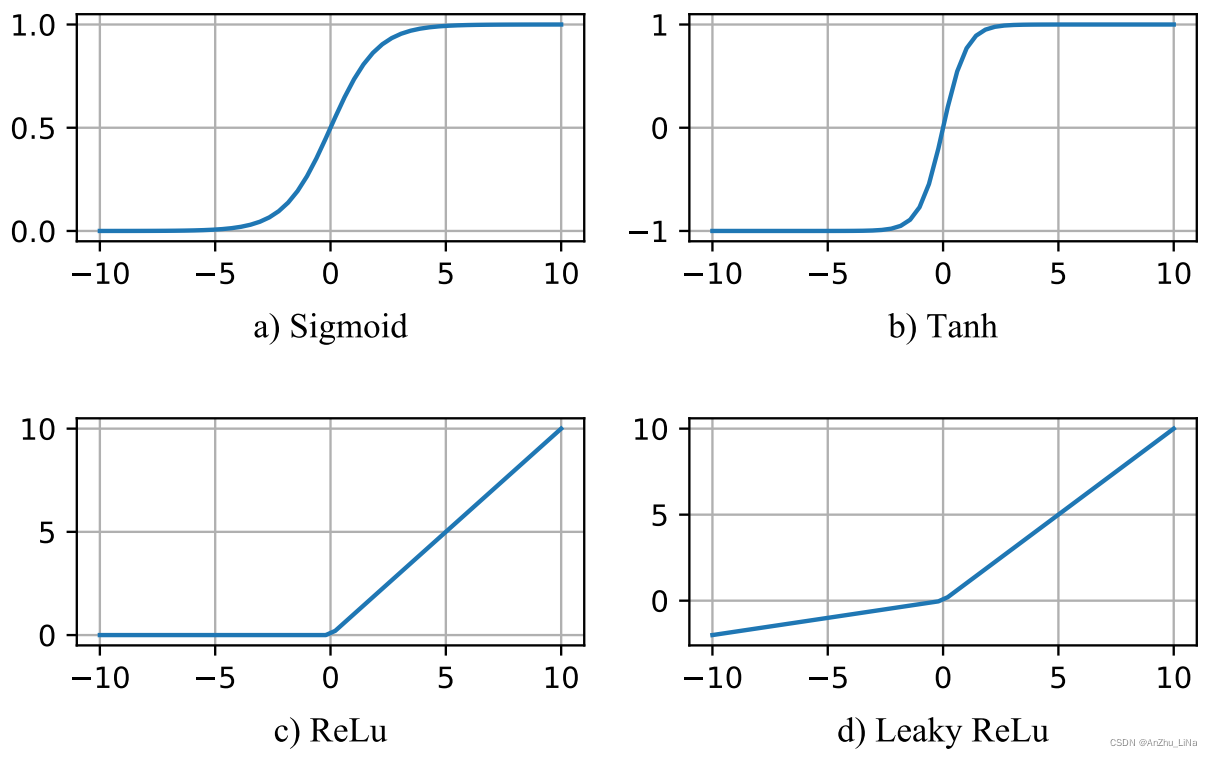

一文带你深度了解relu激活函数!

图片尺寸1280x960

激活函数总结1relu及其变体

图片尺寸916x796

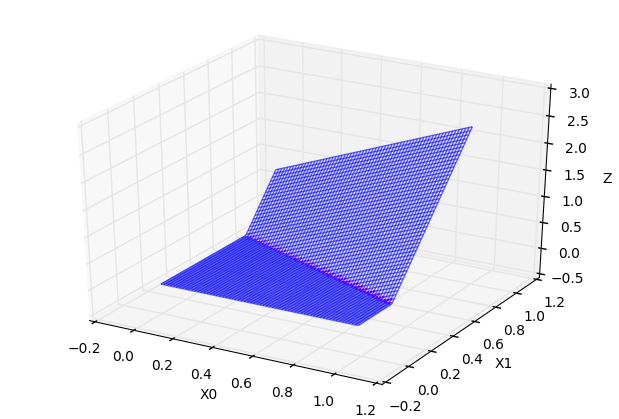

在这里,我在tensorflow上用随机数据训练一个基于l2损失的2层relu

图片尺寸740x617

leaky relu激活函数 - csdn

图片尺寸1212x757

relu函数作用

图片尺寸922x1264

relu神经元函数图像

图片尺寸619x419

2.2 relu激活函数

图片尺寸937x388

relu(rectified linear unit)

图片尺寸512x384

relu

图片尺寸673x535

它有二层,如下表达式,其中σ代表非线性函数relu

图片尺寸602x357