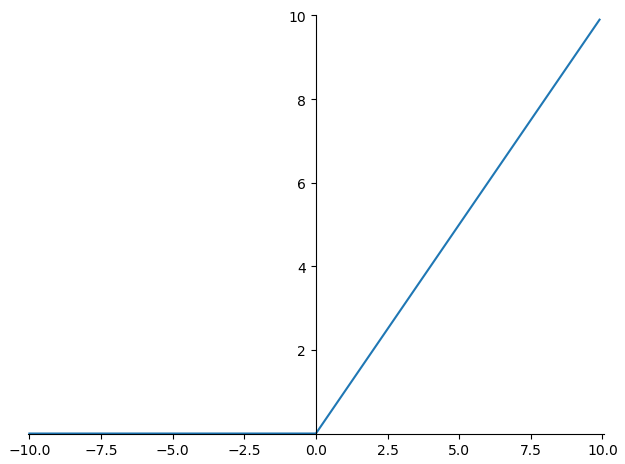

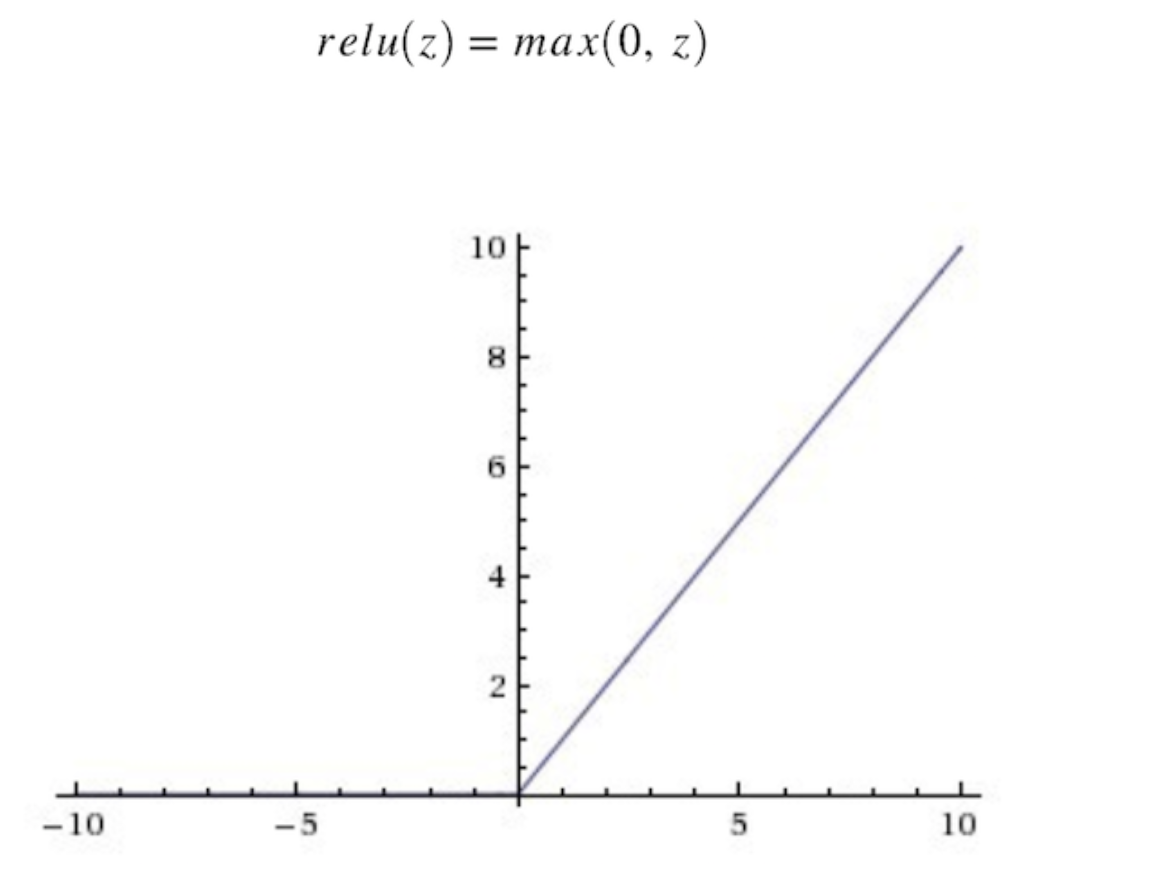

relu函数图像

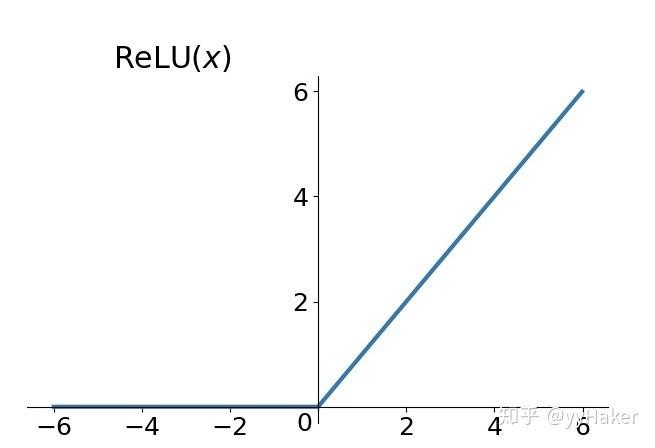

relu函数图像

图片尺寸527x388![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://i.ecywang.com/upload/1/img2.baidu.com/it/u=3144534971,591095494&fm=253&fmt=auto&app=138&f=JPEG?w=640&h=480)

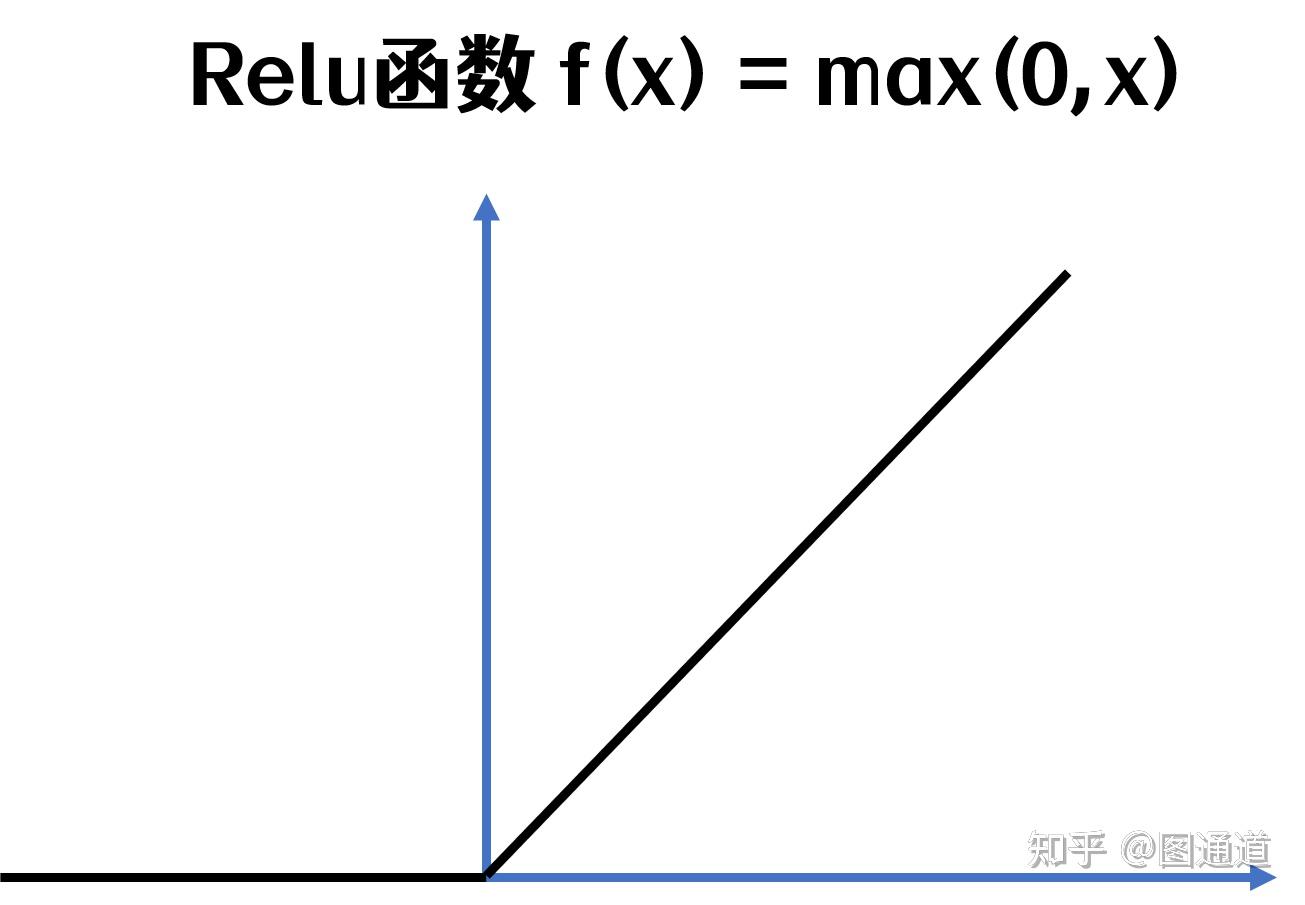

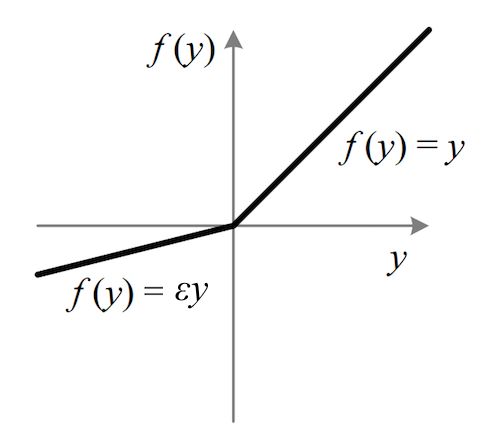

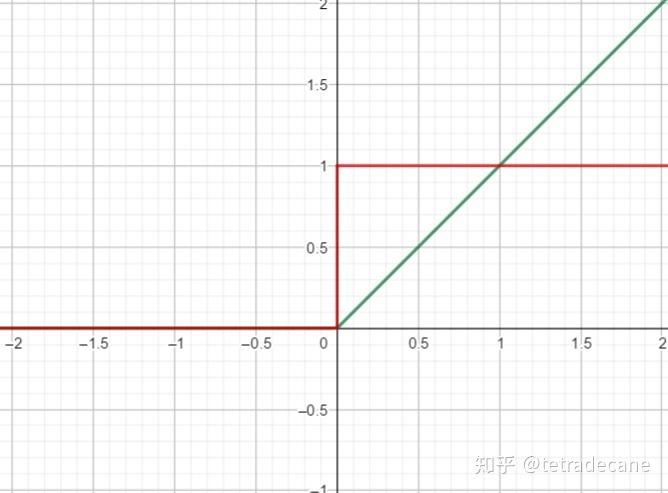

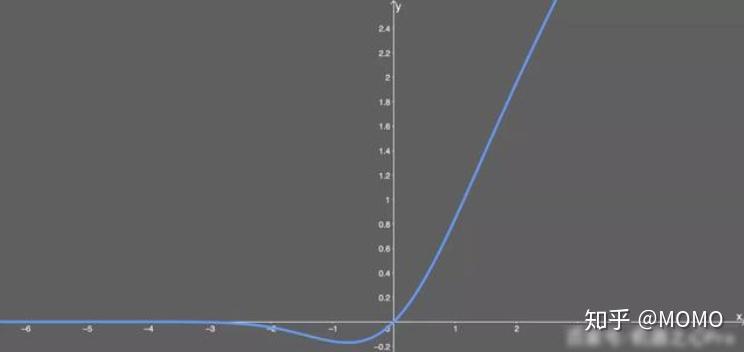

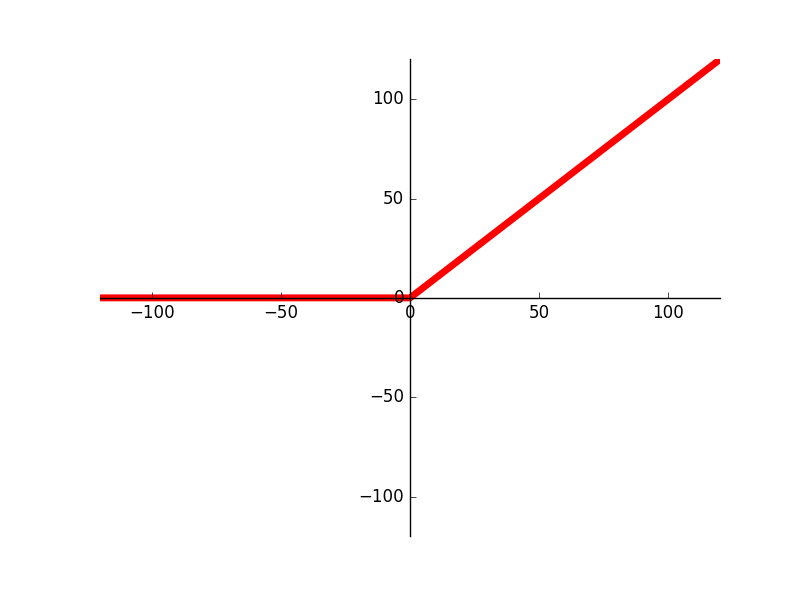

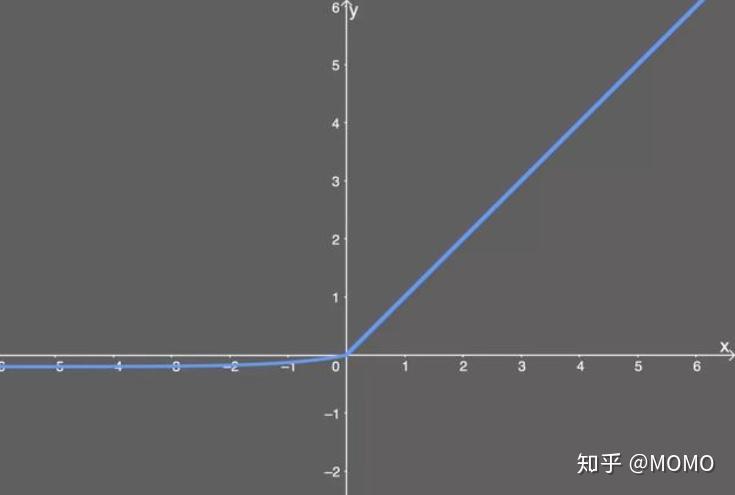

relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下

图片尺寸640x480

优点:收敛速度快相较于sigmoid和tanh函数,relu对于随机梯度下降的

图片尺寸625x464

注意,该函数并非线性,其输出是非线性的. relu 的导数是

图片尺寸640x475

relu的函数图形

图片尺寸608x453

激活层主要对卷积层的输出进行一个非线性映射,在cnn中一般为relu函数

图片尺寸1305x905

relu激励函数曲线fig curveofactivationfunctionrelu

图片尺寸1181x685

linear unit,relu),该函数明显优于前面两个函数,是

图片尺寸396x252

先看sigmoid,tanh和relu的函数图:解析:为什么relu要好过于tanh和

图片尺寸526x541

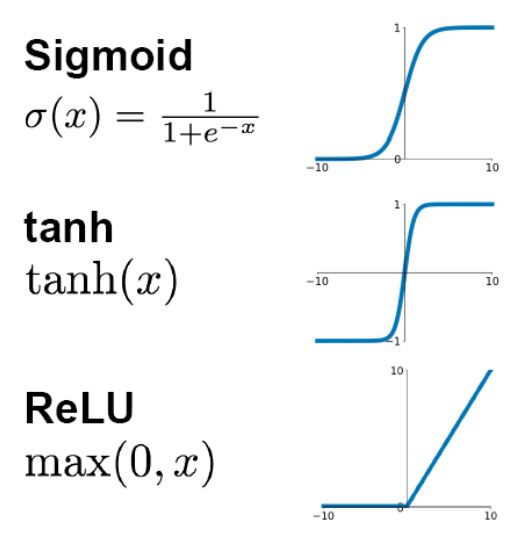

leaky relu函数图像

图片尺寸500x437

mathrm{relu}(x)=max{0,x}\它与它导数的图像:relu函数与其凳数

图片尺寸668x493

激活函数总结1relu及其变体

图片尺寸864x764

激活函数总结1relu及其变体

图片尺寸1228x898

激活函数relu家族

图片尺寸744x352

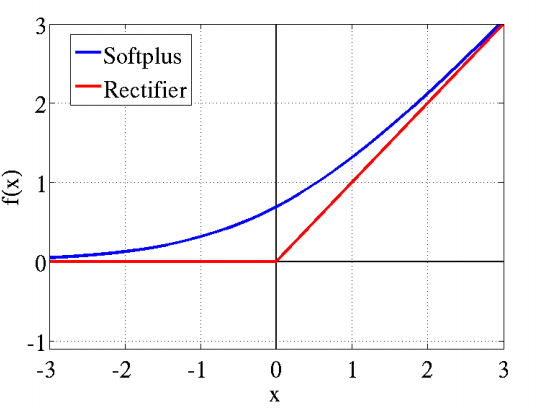

但不平滑,如下图所示:1,整流线性单元(rectifier linear unit, relu)

图片尺寸800x596

激活函数relu家族

图片尺寸735x495

激活函数

图片尺寸1176x888

relu(x) = max(0, x) 3.

图片尺寸655x448

cnn卷积层:relu函数

图片尺寸536x410

relu函数

图片尺寸500x323

![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://i.ecywang.com/upload/1/img2.baidu.com/it/u=3144534971,591095494&fm=253&fmt=auto&app=138&f=JPEG?w=640&h=480)

![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://pics1.baidu.com/feed/03087bf40ad162d947a58504984ebceb8b13cdfc.jpeg?token=bbf567e4a6889a31377c7fecd8dc4130)